김종락 서강대 수학과 교수 연구팀은 지난 15일 국내 5개, 해외 5개 대형언어모델에 수능 수학·논술 문제 등 총 50문제를 풀게 한 평가 결과를 공개했다. 구글의 제미나이 3 프로(Gemini 3 Pro)는 92점, 앤스로픽의 클로드 오퍼스 4.5(Claude Opus 4.5)는 84점을 기록한 반면, 국내 모델들은 20점대에 머물렀다는 내용이다. 이 결과는 국가대표 AI, 이른바 소버린 AI(국가 주권 차원의 독자 AI) 개발 전략 전반에 대한 회의론으로까지 확산됐다.

|

그러나 평가 방식 자체를 문제 삼는 반론이 곧바로 제기됐다. LG AI연구원은 “엑사원(EXAONE) 내부 평가에서는 평균 88점대를 기록했다”며 연구 결과에 반박했다. LG 측은 동일한 수능 수학 문제를 자체 기준으로 여러 차례 반복 평가한 결과라며, 실험 환경과 설정 차이를 고려하지 않은 비교라고 설명했다.

네이버도 벤치마크 설계의 불명확성을 지적하고 나섰다. 이동수 네이버클라우드 전무는 “해당 평가가 어떤 성능을 보려는 실험인지 의도가 명확하지 않다”며 “일반적인 LLM 벤치마크라고 보기 어렵다”고 밝혔다.

특히 그는 이번 실험이 파이썬(Python·프로그래밍 언어) 기반 도구 호출을 전제로 한 에이전틱 AI(agentic AI·목표 달성을 위해 스스로 계획하고 도구를 활용하는 AI) 설정이라는 점을 문제 삼았다. 이동수 전무는 “정답이 나올 때까지 재시도하는 구조로 토큰(token·모델이 처리하는 텍스트 단위) 사용에 사실상 제한이 없는 환경에서, 정답률만으로 성능을 평가하는 것은 의문”이라고 지적했다.

업계에서는 이번 실험이 추론 능력(reasoning) 평가인지, 에이전틱 AI 역량 평가인지, 단순 도구 호출(tool calling) 성능 평가인지 목적이 불분명하다는 비판도 나온다. 이미 글로벌 AI 업계에는 토큰 효율성과 재시도 전략까지 포함한 다양한 벤치마크가 존재하지만, 이번 평가는 설정과 해석이 충분히 공개되지 않은 채 점수만 부각됐다는 것이다.

|

정부는 보다 중장기적인 관점에서 국내 AI 경쟁력을 바라보고 있다. 류제명 과학기술정보통신부 제2차관은 지난 18일 고려대 기술법정책센터가 주최한 세미나에서 “독자 파운데이션 모델(foundation model·다양한 AI 서비스의 기반이 되는 대규모 기본 모델) 구축을 위한 한국의 시도는 해외에서도 글로벌 수준이라는 평가를 받고 있다”고 밝혔다.

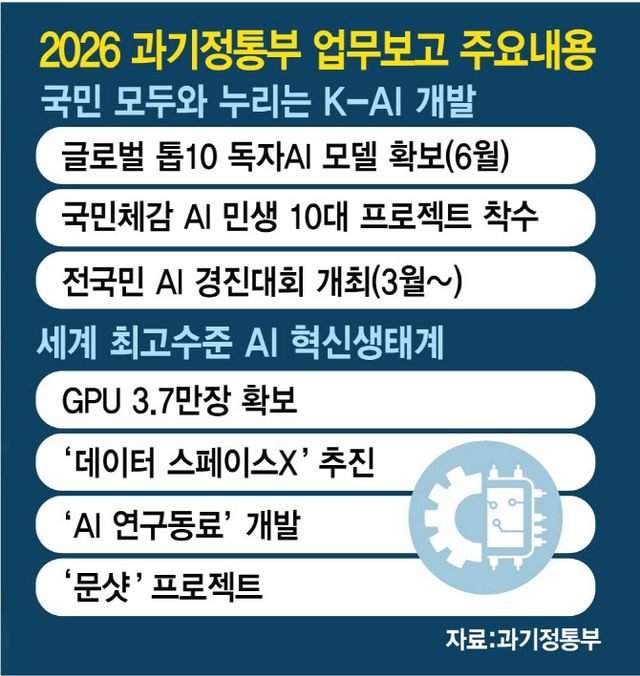

류 차관은 자동차 산업에서 엔진의 중요성을 비유로 들며 “AI 시대의 핵심 엔진에 해당하는 파운데이션 모델을 스스로 확보하려는 전략은 필수”라고 강조했다. 이어 “GPU(Graphics Processing Unit·AI 연산에 특화된 반도체), 데이터, 인재를 결집해 제한된 자원으로 경쟁하는 전략을 택하고 있다”며 “현재 추진 중인 로드맵대로라면 내년 6월에는 세계 10위 수준의 독자 파운데이션 모델을 확보할 수 있을 것”이라고 말했다.

|

전문가들은 이번 논란이 국내 AI의 실력 문제를 넘어, AI 평가 기준과 보도 방식 전반을 되짚는 계기가 되고 있다고 평가한다. 업계 관계자는 “벤치마크의 목적과 조건을 충분히 설명하지 않은 채 수능 점수만 강조하면 기술 논의를 왜곡할 수 있다”며 “산업과 정책 판단에 영향을 미치는 만큼 보다 정교하고 투명한 평가가 필요하다”고 말했다.

Copyright ⓒ 이데일리 무단 전재 및 재배포 금지