김정호 한국과학기술원(KAIST) 전기전자공학부 교수는 3일 서울 중구 프레스센터에서 열린 ‘HBF 연구내용 및 기술개발 전략 설명회’에서 이같이 말했다. 인공지능(AI) 기술이 지속 성장하면서 메모리에 대한 수요도 폭발적으로 늘어나는 가운데, HBM을 넘어 HBF가 차세대 핵심 기술로 부상할 것이라는 분석이다.

|

이번 설명회에서는 ‘HBM의 아버지’로 불리는 김 교수가 이끄는 KAIST 테라랩이 현재 AI 기술 발전 동향과 메모리 로드맵 등에 대해 소개했다. 김 교수는 우리나라가 세계 최초로 상용화에 성공한 AI 반도체 핵심 기술인 HBM의 기본 개념과 구조를 창안하고 설계한 전문가다.

김 교수는 AI 기술이 점점 고도화하면서 더이상 추론과 학습을 분리해서 보는 시각이 유효하지 않다고 봤다. 그는 “이제는 AI가 사전 학습을 통해 최신 자료를 학습하고 추론하는 과정이 실시간으로 일어나고 있다”며 “또 정해진 기한이 없이 평생 학습을 한다는 점에서 데이터양과 필요한 메모리의 양이 늘어날 수밖에 없다”고 했다. 김 교수는 향후 메모리 수요가 100배~1000배까지 늘어날 수 있다고 내다봤다.

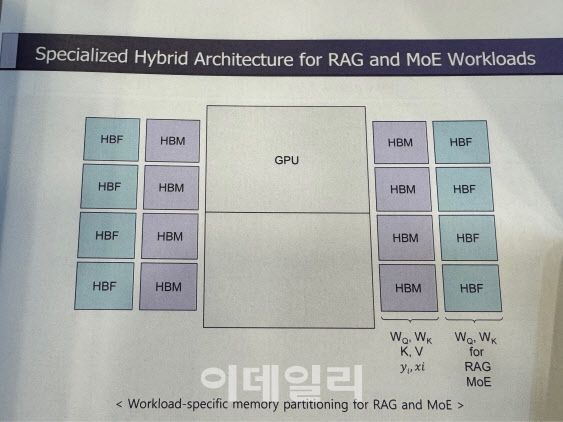

이같은 상황에서 삼성전자와 SK하이닉스 등 메모리 반도체 기업들은 차세대 HBM을 개발하며 용량 증가에 대응하고 있다. 다만 HBM만으로는 폭발적으로 늘어나는 용량에 대응할 수 없는 만큼, 결국 업계에서 HBF를 채택할 수 없을 것이라고 김 교수는 전망했다. 현재는 그래픽처리장치(GPU)를 수직으로 최대 2개까지 연결하고 GPU 옆에 HBM을 붙여 연산을 담당하는 구조였다면, 앞으로는 HBM과 HBF를 함께 붙여 용량 한계를 없앨 수 있다는 것이다.

|

이날 김 교수는 HBF를 활용한 차세대 메모리 아키텍처를 공개했다. GPU 양옆에 각각 4개의 HBM과 HBF를 붙여 총 96기가바이트(GB)의 HBM 용량과 2테라바이트(TB)의 HBF 용량을 갖춘 아키텍처를 비롯해 각각 8개의 HBM·HBF가 두 줄씩 붙어 더 많은 용량을 처리할 수 있는 구조 등을 제시했다.

김 교수는 “HBM은 서고, HBF는 도서관 역할을 각각 하게 될 것”이라며 “서고에서는 필요한 책을 바로 뽑아 볼 수 있고, 도서관에서는 조금 느리더라도 한 번에 더 많은 책을 볼 수 있게 되는 것”이라고 강조했다.

현재 삼성전자와 SK하이닉스, 샌디스크 등 글로벌 기업들은 HBF 개발에 속도를 내고 있다. 김 교수는 국내 기업들이 더 유리한 고지를 점하고 있다고 봤다. 샌디스크는 낸드플래시에만 집중하고 있지만, 삼성전자와 SK하이닉스는 HBM과 패키징 역량 등을 모두 보유하고 있기 때문이다. 그는 “구조적인 변화 속 10~20년 후에 AI 컴퓨터를 한국이 주도할 수 있게 될 것”이라며 “그 중 허리에 해당하는 것이 바로 HBF”라고 말했다.

엔비디아도 올해 CES 2026에서 데이터 처리 유닛(DPU)과 솔리드 스테이트 드라이브(SSD)를 직접 연결해 추론 과정에서 누적되는 이전 대화 맥락인 KV 캐시를 HBM이 아닌 대용량 SSD에 저장하는 방식을 공개하면서 낸드플래시 기반 메모리 병목 해결 방안을 제시한 바 있다. 김 교수는 엔비디아를 비롯해 구글, AMD 등 빅테크 기업들과 협업해 시장을 선점할 필요가 있다고 강조했다. 김 교수는 “HBF 공정은 기존 HBM의 공정과 거의 유사한 만큼 결국 기술 속도전이 될 것”이라며 “본격 상용화를 위해서는 어떤 서비스에 채택되느냐가 중요할 것으로 보인다”고 말했다.

Copyright ⓒ 이데일리 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.