개발자 채용 평가 현장에 인공지능(AI)을 허용하는 시도가 본격화되고 있다.

AI 기반 온라인 코딩 테스트 플랫폼 ‘모니토’를 운영하는 그렙이 개발자의 AI 협업 능력을 직접 평가하는 신규 기능 ‘AI 어시스트(AI Assist)’를 정식 출시했다.

그렙은 15일 “실무 현장에서 이미 AI 활용이 보편화된 상황에서, 채용 평가만 AI 사용을 막는 방식은 현실과 맞지 않는다”며 AI 어시스트 도입 배경을 설명했다. 개발자가 AI와 함께 문제를 해결하는 과정 자체를 평가 지표로 삼겠다는 접근이다.

실제 개발 현장에서는 챗GPT, 깃허브 코파일럿 등 생성형 AI 도구 활용이 일상으로 자리 잡았다. 마이크로소프트와 링크드인 조사에 따르면 지식 근로자의 75%가 업무에 AI를 활용하고 있으며, 테스트고릴라의 2025년 보고서에서도 기술 기반 채용을 도입한 기업 비율이 85%에 달했다. 반면 채용 평가에서는 여전히 부정행위 방지를 이유로 AI 사용을 일괄 금지하는 경우가 대부분이었다.

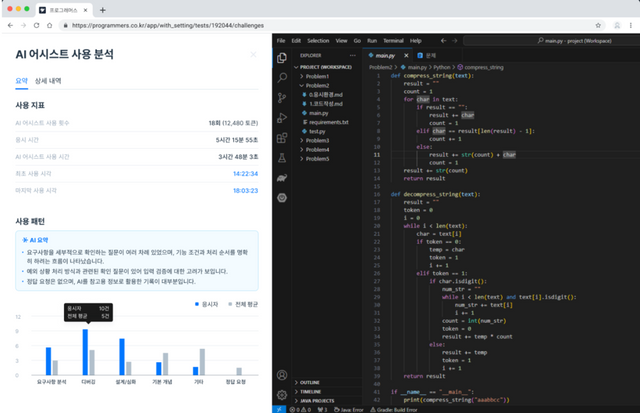

AI 어시스트는 이 간극을 줄이기 위해 설계됐다. 응시자는 시험 중 표준화된 AI 환경에서 실시간으로 AI와 소통하며 코드 작성, 오류 수정, 문제 해결을 진행할 수 있다. 채용 기업은 결과물만 보는 방식에서 벗어나 응시자가 어떤 프롬프트를 입력했고, AI의 답변을 어떻게 해석하고 수정했는지까지 확인할 수 있다.

특히 질문 횟수, 토큰 사용량, 응답 대기 시간 같은 세부 데이터가 함께 제공된다. 효율적인 질문으로 핵심 해답을 끌어낸 지원자와 반복적인 시행착오에 의존한 지원자를 구분할 수 있다는 설명이다. AI 활용 능력을 정성 평가가 아닌 수치 기반 지표로 제공하겠다는 시도다.

보안 문제도 강조했다. 모든 AI 요청은 그렙의 자체 중계 서버를 거쳐 관리되며, 외부 문제 유출이나 비인가 접근 가능성을 차단했다. 그렙이 기존 온라인 시험에서 축적해온 부정행위 방지 기술을 AI 환경에도 적용했다는 설명이다.

다만 업계에서는 평가 기준의 표준화 여부가 관건이라는 시각도 나온다. AI 활용이 능숙하다는 점과 실제 개발 역량 사이의 상관관계를 어떻게 정의할지, 기업별로 요구하는 AI 활용 수준이 다른 상황에서 평가 결과를 어디까지 신뢰할 수 있을지에 대한 검증이 필요하다는 지적이다.

그렙은 상반기 중 ‘AI 에이전트’ 기능을 추가한 고도화 버전을 공개할 계획이다. AI가 시험 문제의 맥락과 프로젝트 파일 구조를 이해하고, 다중 파일 기반의 버그 수정 등 실제 업무 환경에 가까운 과제를 지원하는 방식이다. 단일 알고리즘 문제가 아닌 실무형 프로젝트 평가로 영역을 넓히겠다는 구상이다.

임성수 그렙 대표는 “개발자는 이미 AI와 함께 일하고 있다”며 “AI가 제시한 답을 그대로 쓰는지가 아니라, 그 결과를 검증하고 개선하는 판단력이 중요해지고 있다”고 말했다. 이어 “AI 감독 기술을 바탕으로 채용 평가의 기준을 현실에 맞게 재정의하겠다”고 덧붙였다.

그렙은 장기적으로 AI 어시스트를 채용 평가에 그치지 않고 직무 교육과 조직 단위 역량 관리로 확장할 계획이다. 개발 조직 전반의 AI 활용 수준을 체계적으로 관리하는 플랫폼으로 발전시키겠다는 전략이다.

개발자 채용 시장에서 ‘AI를 썼는가’가 아니라 ‘AI를 어떻게 썼는가’를 묻는 평가가 정착할 수 있을지, 그렙의 시도가 하나의 기준으로 자리 잡을지 주목된다.

Copyright ⓒ 스타트업엔 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.