우리는 이제 인공지능(AI)이 선별한 뉴스를 읽고, AI가 추천한 상품을 구매하는 진정한 AI 시대에 살고 있다. AI가 '효율'의 상징이 된 셈이다. 그러나 알고리즘 이면에 숨겨진 '편향'은 우리 사회의 새로운 갈등의 씨앗이 되고 있다.

이에 AI포스트(AIPOST)는 한국지능정보사회진흥원(NIA) 디지털포용본부 고현지 선임의 심층 보고서 'AI 편향으로 인한 사회적 갈등과 정책적 대응'을 바탕으로 알고리즘이 초래한 사회적 균열의 실태를 파헤치고 디지털 상생을 위한 정책적 해법을 제시하고자 시리즈를 기획했다. <편집자주>

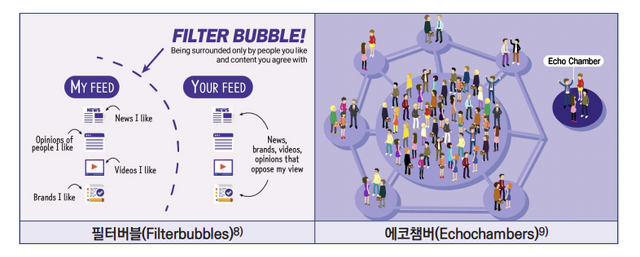

인공지능(AI) 알고리즘은 친절하다. 이용자가 좋아할 만한 뉴스, 사고 싶어 할 만한 상품을 귀신같이 찾아내 내민다. 하지만 이 달콤한 맞춤형 서비스의 이면에는 '나만의 진실'에 갇히게 만드는 거대한 벽이 세워지고 있다. 이른바 '필터버블(Filter Bubble)'과 '에코챔버(Echo Chamber, 반향실)' 현상이다.

알고리즘이 가둔 세상, ‘확증 편향’의 악순환

AI 추천 알고리즘은 이용자의 과거 취향을 학습해 비슷한 콘텐츠만을 반복적으로 노출시킨다. 이 과정에서 이용자는 자신의 신념과 일치하는 정보만 수용하고, 반대되는 정보는 철저히 차단되며 다양한 의견·관점으로부터 고립되는 '필터버블'에 갇히게 된다.

문제는 이것이 개인의 취향을 넘어 사회적 갈등의 증폭기가 된다는 점이다. 보고서는 "필터버블로 인해 개인이 자신의 기존 신념이나 가치관을 강화하는 정보만을 선택적으로 수용하고, 이에 반하는 정보는 무시하거나 과소평가하는 인지적 편향인 확증편향이 강화된다"라고 분석했다.

결국 같은 알고리즘을 공유하는 집단 내에서는 신념이 극단화되고, 타 집단에 대한 혐오와 배척이 정당화되는 '에코챔버' 현상이 발생하며 민주주의의 기초인 공론장이 소리 없이 붕괴되고 있다.

EU·미국 상황은 어떨까?…‘기울어진 알고리즘’에 선전포고

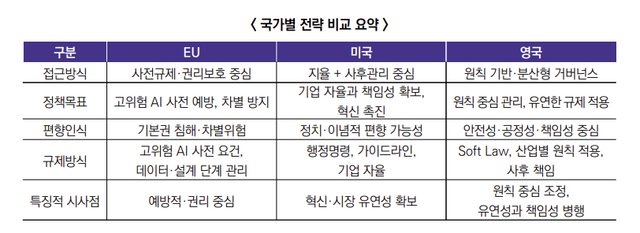

상황이 심각해지자 세계 각국은 AI 편향을 막기 위한 정책적 장치 마련에 분주하다. 먼저 유럽연합(EU)은 지난 2024년 12월 세계 최초로 통과된 'AI 법(AI Act)'을 통해 인종, 정치적 견해, 종교 등 민감한 특성을 기준으로 하는 편향적 분류 시스템을 엄격히 규제하기 시작했다.

특히 고위험 AI에 대해서는 엄격한 법적 의무를 부과함으로써, 편향의 근본적 원인을 통제하고 있다. 알고리즘으로 인한 편향보다는 성별, 나이, 장애 등 데이터 자체의 편향에 더 초점을 맞추고 있다.

미국은 바이든 정부의 'AI 권리장전'을 통해 알고리즘이 특정 계층을 차별하는 것을 방지하는 ‘알고리즘 형평성’ 원칙을 공표했다. 최근의 행정명령은 기업들에게 AI 시스템의 작동 원리를 설명할 책임을 부여하고, 학습 데이터의 대표성을 확보해 소수자에 대한 편견이 개입되지 않도록 엄격한 사전 평가를 권고하고 있다.

이는 AI가 민주적 가치를 훼손하지 않도록 기업에 투명한 ‘설명 의무’를 강하게 압박하는 기조다. 이러한 글로벌 흐름의 핵심은 단순한 기술적 권고를 넘어, AI가 초래할 수 있는 '사회적 위험도'에 따라 차등적인 규제를 적용하고 개발사의 책임을 명문화하는 방향으로 흐르고 있다.

"신뢰할 수 있는 AI 사회를 위한 3대 전략"

NIA 연구진은 우선 개발 및 운영 전 과정의 기술적 투명성을 높여 알고리즘의 설명 가능성을 확보해야 하며, 무엇이 공정한지 결정하는 사회적 공론화가 선행돼야 한다고 진단했다. 아울러 이용자가 스스로 편향을 인지할 수 있는 디지털 리터러시 교육의 병행도 강조했다.

우선 기술적 투명성과 신뢰성 확보가 필수적이다. 기업이 알고리즘의 의사결정 과정을 공개하고 독립적 검증 기구를 도입해야 한다는 것이다. 이어 무엇이 '공정한 AI'인지에 대한 사회적 공론화와 사용자가 편향 가능성을 인지하는 디지털 리터러시 강화가 병행되어야 한다고 조언했다.

NIA 디지털포용본부 고현지 선임은 "AI 편향 대응은 단순히 기술적 오류를 수정하는 차원을 넘어 민주적 가치를 수호하고 디지털 포용을 실현하기 위한 필수 과제"라고 분석했다. 이어 "AI가 사회적 공정성을 갖추기 위해서는 범사회적 합의를 통해 우리 사회의 올바른 기준을 먼저 정립해야 한다"고 덧붙였다.

Copyright ⓒ AI포스트 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.