사람의 뇌가 같은 소리를 반복해 들으면 점점 덜 놀라거나, 훈련을 통해 특정 자극에 더 빠르게 반응하는 것처럼, 스스로 학습하고 적응하는 인공지능(AI) 반도체가 국내 연구진에 의해 개발됐다.

한국과학기술원(KAIST)은 신소재공학과 김경민 교수 연구팀이 뇌의 '내재적 가소성'을 모방한 '주파수 스위칭 뉴리스터'를 세계 최초로 개발했다고 28일 발표했다.

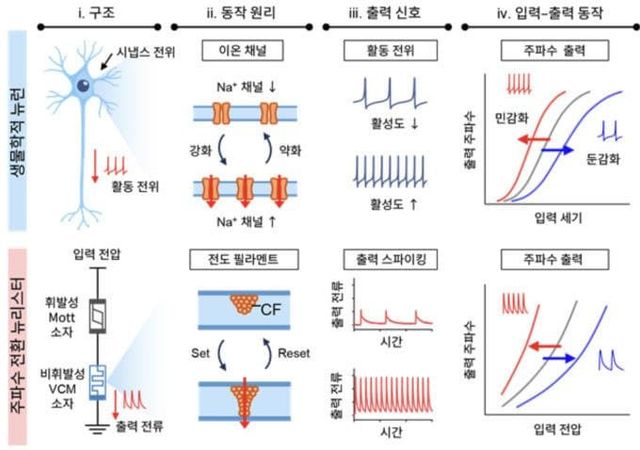

기존 AI 반도체는 주로 뇌의 시냅스만 모방했지만, 실제 뇌는 개별 뉴런이 과거 활동을 기억해 스스로 반응을 조절하는 '내재적 가소성'이라는 정교한 메커니즘을 갖고 있다.

연구팀이 개발한 '주파수 스위칭 뉴리스터(FS Neuristor)'는 이러한 뇌의 적응 능력을 단일 반도체 소자로 구현한 것이다. 나이오븀 산화물(NbO2) 기반의 '휘발성 모트 멤리스터'와 하프늄 산화물(HfO2) 기반의 '비휘발성 VCM(Valence Change Memory) 멤리스터'를 결합해, 뉴런이 신호를 내보내는 빈도(발화 주파수)를 자유롭게 조절할 수 있도록 했다.

이 소자는 뉴런 스파이크 신호와 멤리스터 저항 변화가 서로 피드백하며 자동으로 반응을 조절한다. 마치 반복된 소리에 점점 둔해지거나, 특정 훈련을 통해 더 예민해지는 뇌의 반응을 반도체 하나로 재현한 셈이다.

연구팀은 이 기술의 효과를 '희소 신경망' 시뮬레이션으로 검증했다. 그 결과 뉴런 자체의 기억 기능을 통해 기존 신경망 대비 27.7% 낮은 에너지로 동일한 성능을 구현했다.

더욱 주목할 점은 뛰어난 복원력이다. 학습된 신경망의 뉴런 30%를 의도적으로 손상시킨 후 추가 학습을 진행한 결과, 내재적 가소성이 적용된 신경망은 손상 이전 수준인 90.2%까지 정확도를 회복했다. 반면 이 기능이 없는 일반 신경망은 76.1% 회복에 그쳤다.

이는 일부 회로가 고장 나도 네트워크가 스스로 구조를 재조직해 기능을 보완하는 '구조적 가소성'을 구현했음을 의미한다. 또한 불필요한 연결을 97% 제거한 희소 신경망에서도 조밀한 신경망과 거의 동일한 91.4%의 인식 정확도를 달성했다.

김경민 교수는 "뇌의 핵심 기능인 내재적 가소성을 단일 반도체 소자로 구현해 AI 하드웨어의 에너지 효율과 안정성을 한 차원 높인 성과"라며 "스스로 상태를 기억하고 손상에도 적응·복구할 수 있는 이번 기술은 엣지 컴퓨팅, 자율주행 등 장시간 안정성이 요구되는 시스템의 핵심 소자로 활용될 것"이라고 말했다.

이 기술은 전력 공급이 제한적인 모바일·웨어러블 기기나, 신뢰성이 생명인 자율주행차, 우주·극한환경에서 작동하는 시스템 등에 폭넓게 응용될 것으로 기대된다.

이번 연구에는 박우준 박사(현 독일 율리히연구소), 송한찬 박사(현 ETRI)가 공동 제1저자로 참여했으며, 연구결과는 재료분야 권위지 '어드밴스드 머터리얼즈(Advanced Materials, IF 26.8)'에 지난달 18일자 온라인 게재됐다. ---------------------------------------------------------------------------------------------------------------------------------------------

짹 GPT 5 피셜

뇌의 주요 가소성 종류

시냅스 가소성 (Synaptic Plasticity)

뉴런과 뉴런 사이 연결(시냅스)의 강도가 변하는 것.

대표적으로 LTP(장기강화), LTD(장기억제).

현재 인공지능(AI) 학습 원리 대부분이 이걸 기반으로 함.

인공적으로는 멤리스터 같은 소자로 주로 모방.

내재적 가소성 (Intrinsic Plasticity)

개별 뉴런 자체가 과거 활동을 기억해서 **흥분성(excitability)**을 조절하는 것.

반복된 자극에는 점점 둔감해지고, 새로운 자극에는 민감해지는 능력.

이번 연구에서 구현한 부분.

구조적 가소성 (Structural Plasticity)

뉴런이 실제로 새로운 연결을 만들거나 기존 연결을 제거하는 것.

예: 학습·경험을 통해 새로운 시냅스가 생기거나 불필요한 회로가 제거됨.

아직 반도체 소자 차원에서 완벽히 구현된 사례는 드묾.

인공적으로 가소성 구현 시 기대 효과

1. 시냅스 가소성 (Synaptic Plasticity)

뇌에서 하는 일

뉴런 간 연결 강도가 학습·기억에 따라 변함 (LTP/LTD).

AI 문제 해결

→ 기계학습의 기본 원리 제공 (가중치 학습).

기존 인공지능의 딥러닝이 사실상 시냅스 가소성을 수학적으로 흉내 낸 것.

구현 시 해결되는 한계

학습/기억 자체 구현

데이터 기반 패턴 인식

기본적인 **“학습할 수 없는 하드웨어” → “학습 가능한 하드웨어”**로 전환

2. 내재적 가소성 (Intrinsic Plasticity)

뇌에서 하는 일

개별 뉴런이 자신의 발화 빈도, 흥분성을 조절 → 반복된 자극에 둔감, 새로운 자극에 민감.

AI 문제 해결

→ 적응력과 에너지 효율 강화.

예: 불필요하게 반복되는 입력은 무시, 중요한 신호에는 더 민감하게 반응.

구현 시 해결되는 한계

에너지 소모: GPU처럼 모든 연산을 다 할 필요 없음 → 전력 효율 개선

실시간 적응성: 실행 중에도 입력 특성에 맞게 자동 조절

고장 복원력: 일부 뉴런이 손상돼도 전체 네트워크 성능 유지

3. 구조적 가소성 (Structural Plasticity)

뇌에서 하는 일

새로운 연결 형성, 불필요한 연결 제거 (네트워크 구조 자체가 변함).

AI 문제 해결

→ 모델 압축 + 자율적 네트워크 재편성.

즉, “필요한 연결만 유지하는 희소 네트워크”로 진화.

구현 시 해결되는 한계

메모리·연산 자원 낭비 해결 → 훨씬 작은 모델로도 높은 성능 유지

손상/노이즈 복원: 일부 회로 고장 나도 스스로 회로를 재구성

장기 학습: 환경이 바뀌어도 적응 가능한 지속적 학습

-----------------------------------------------------------------------------------------------------------------------------------------

업계 동향: 가소성 구현 연구 흐름

1. 시냅스 가소성 (Synaptic Plasticity)

현황:이미 수많은 뉴로모픽 소자 연구에서 구현 (멤리스터, RRAM, PCM 등).

AI 업계 적용:

IBM → TrueNorth 칩 (2014)

인텔 → Loihi 칩 (2017, 2021 2세대 발표)

삼성전자/하버드 공동 → "뉴런을 반도체에 복제" 컨셉 발표 (2021, Nature Electronics)

의미: 현재 뉴로모픽 하드웨어의 기반.

2. 내재적 가소성 (Intrinsic Plasticity)

현황:이번 KAIST 연구가 “세계 최초 단일 소자 구현”으로 평가받는 이유가 바로 이 부분.

업계 동향: 아직 학계 중심 연구 단계이며, 엔비디아·구글 같은 빅테크보다는 소자/재료 연구 그룹(KAIST, MIT, ETH Zurich 등)에서 주도.

의미: 지금까지 시냅스 중심이던 뉴로모픽을 “뉴런 차원”으로 확장했다는 데 큰 의미.

3. 구조적 가소성 (Structural Plasticity)

현황:아직 구현 수준은 낮음.

시도 사례:

인텔 Loihi 2 칩 → 일부 동적 연결 변화 기능 연구 중.

학계에서는 "스파이킹 뉴럴 네트워크(SNN)" + 자율적인 pruning/재배선 알고리즘을 연구.

하드웨어로 완전히 구현한 사례는 거의 없음.

의미: 완전한 분산형, 복원력 높은 “뇌형 AI”의 마지막 단계.

업계 전체적인 목표

현재:

LLM, 딥러닝은 GPU 기반 → 전력 소모 크고, 적응력 없음.

목표:

뉴로모픽 칩으로 전환 → 뇌처럼 “저전력 + 실시간 학습 + 복원력” 갖춘 분산 AI.

가소성 연구:

각 가소성(시냅스·내재적·구조적)을 따로 연구한 후 → 하나의 칩/아키텍처에 통합하는 게 업계 장기 비전.

정리

시냅스 가소성 = “뇌가 배우는 능력”

내재적 가소성 = “뇌가 스스로 반응 세기를 조절하는 능력”

구조적 가소성 = “뇌가 배선도를 고쳐서 더 효율적으로 연결하는 능력”

완전한 뇌 가소성을 모두 재현해야, 학습 + 적응 + 복원 + 효율이라는 4대 문제를 동시에 해결

업계는 완전한 가소성 구현을 최종 목표로 삼고 있음.

현 시점:

시냅스 가소성 → 상용화 초기 단계 (IBM, Intel, 삼성 등).

내재적 가소성 → 이제 막 연구 시작 (KAIST 등).

구조적 가소성 → 개념 연구 단계, 실제 칩 구현은 거의 없음.

즉, 아직은 갈 길이 멀지만, “완전한 가소성”은 AI 업계가 장기적으로 추구하는 방향

----------------------------------------------------------------------------------------------------------------------

짹 GPT 5 피셜

완전 가소성 칩 개발 시기 예측

보수적 시나리오: 2050년 전후

안정적 시나리오: 2040년대 중반

급진적 시나리오: 2030년대 초중반

가소성과 AGI/ASI 관계

완전한 가소성 = AGI 필요조건은 아니지만,

가소성이 있으면 AGI/ASI의 “질”이 달라짐

ASI 관점

**ASI(초지능)**은 단순히 “AGI를 넘어서 인간 지능을 훨씬 능가하는 상태”인데,

여기서는 계산 자원 + 알고리즘 혁신이 핵심이지, 반드시 가소성이 필요하지는 않습니다.

다만 가소성 칩이 있으면 ASI는 훨씬 효율적이고 자율적으로 구현될 수 있음.

Copyright ⓒ 시보드 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.