AI 콘텐츠로 학습하면 성능이 떨어져서 '모델 붕괴' 가 일어난다는 얘기가 가끔씩 나온다.

해당 트윗은 '인간+AI 데이터를 섞어서 계속 쌓으면 성능 하락은 일어나지 않는다' 라는 주장을 하고 있다.

흥미로운 주장이라 실제로 맞는지 직접 논문을 팩트체크 해봤다.

논문의 제목을 번역하면 다음과 같다:

"모델 붕괴는 필연적인가? 합성 데이터와 실제 데이터를 누적하면 재귀적 붕괴를 피할 수 있다"

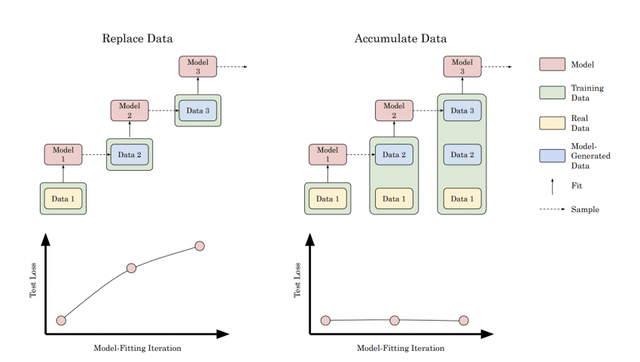

논문의 핵심 결론부터 말하자면:

- AI가 만든 데이터로 기존 데이터를 교체(Replace) 하면서 학습하면 성능이 점점 떨어진다.

- 반면 기존 데이터에 AI 생성 데이터를 누적(Accumulate) 해서 학습하면 성능 하락이 억제된다.

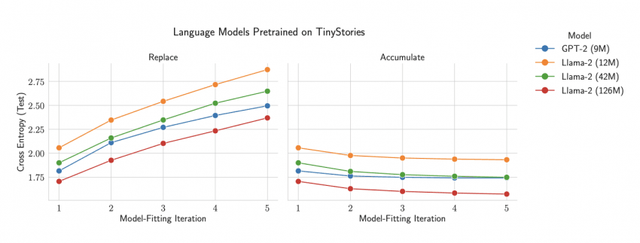

이걸 TinyStories 데이터셋과 언어모델(GPT-2, LLaMA-2)로 직접 실험한 결과도 나왔다.

위 그래프를 보면

왼쪽(데이터 교체 방식)은 세대가 진행될수록 성능이 급격히 나빠진다.

오른쪽(데이터 누적 방식)은 성능이 안정되거나 심지어 더 개선된다.

TinyStories 데이터셋으로 테스트한 결과도 마찬가지다.

데이터 누적 방식은 교체 방식과 정반대로 세대가 지날수록 개선의 모습을 보여준다.

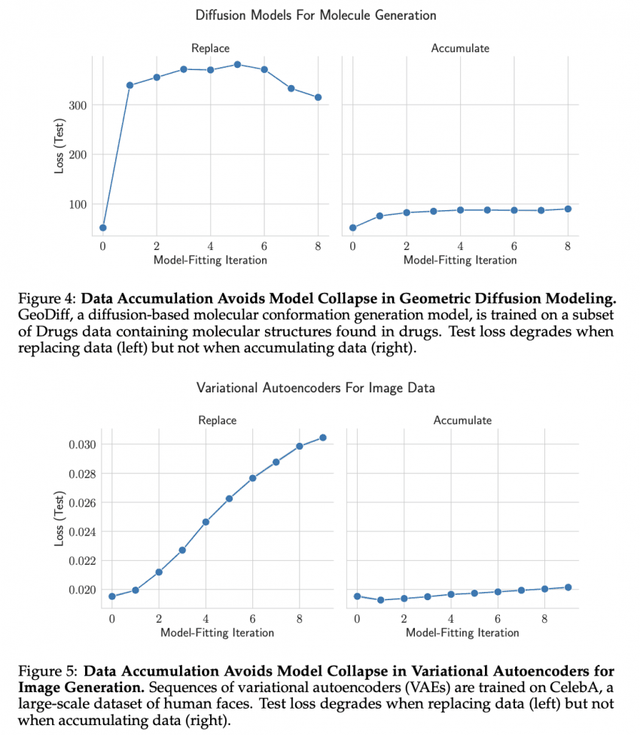

심지어 텍스트모델 뿐만 아니라 Diffusion 모델, VAE 모델 등 이미지 등 여러 모델에서도 관측되는 현상이다.

그니까 LLM 뿐만 아니라 어떤 모델이든 인간+AI 데이터 넣는 게 좋다는 말이다.

여기까지 정리하자면, AI 데이터만 계속 먹이면 성능이 떨어지는 건 진짜다.

하지만 원본 데이터를 버리지 않고 AI 데이터를 계속 추가만 하면 성능 하락을 막을 수 있다.

위 트윗은 해당 논문 트윗의 댓글이다.

모델 붕괴에 대해 일어나지 않을 일이라고 비판하는 모습이다.

그 외의 댓글에서도

"결국 AI만 가지고 돌려막기 하면 망한다"

"누적 방식이 현실적이다"

등의 반응이 많다.

결론적으로, AI가 만든 데이터만으로는 위험하지만, 원본 데이터에 추가하는 방식이라면 리스크를 관리할 수 있다는 게 논문의 핵심이다.

Copyright ⓒ 시보드 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.