손·물체 가려져도 전체 형상 예측…"VR·AR 분야 활용"

(울산=연합뉴스) 김용태 기자 = 양손으로 어떤 물체를 다룰 때 보이지 않는 부분까지 3차원으로 나타내는 인공지능(AI) 기술을 울산과학기술원(UNIST) 연구진이 개발했다.

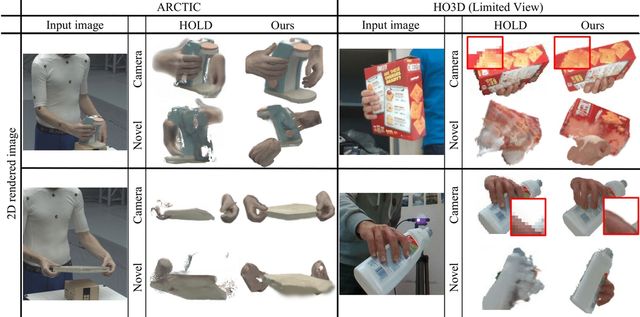

UNIST 인공지능대학원 백승렬 교수팀은 단일 RGB 영상만으로 양손과 처음 보는 기구의 복잡한 상호작용을 실시간 3D로 시각화할 수 있는 AI 모델 'BIGS'(Bimanual Interaction 3D Gaussian Splatting)를 개발했다고 9일 밝혔다.

AI는 카메라로 촬영된 2D 데이터만 입력받기 때문에 손과 물체의 실제 위치나 입체적인 형태를 파악하려면 3차원으로 전환하는 과정이 필요하다.

기존 기술은 한 손만 인식하거나 사전에 스캔 된 물체만 대응할 수 있었다.

이 때문에 가상현실(VR)이나 증강현실(AR) 기술에서 현실감 있는 상호작용 장면을 재현해내는 데 한계가 있었다.

연구팀이 개발한 모델은 손이 가려지거나 일부만 보이는 상황에서도 전체 형상을 안정적으로 예측할 수 있고, 처음 보는 물체도 학습된 시각 정보를 통해 보이지 않는 부분까지 자연스럽게 그려낼 수 있다.

깊이 센서나 여러 각도의 카메라 없이 단 한 대의 카메라로 찍은 단일 RGB 영상만으로 이 같은 복원이 가능해 현장에서 쉽게 적용할 수 있다고 연구팀은 설명했다.

이 모델은 사물의 형상을 퍼지는 점 구름 형태로 표현하는 방식인 3D 가우시안 스플래팅(Gaussian Splatting)을 기반으로 한다. 픽셀 단위로 경계가 뚜렷한 포인트 클라우드 방식과 달리 손과 물체가 만나는 접촉면 등을 더 자연스럽게 나타낼 수 있다.

손이 겹치거나 일부가 가려진 상황에서는 모든 손을 하나의 기준 손 구조에 맞춰 정렬하는 방식을 이용해 해결했다. 또 학습된 확산 모델을 활용한 점수 증류 방식을 적용해 영상에 보이지 않는 물체의 뒷면까지 복원한다.

국제 데이터 세트를 활용한 실험 결과 손의 자세, 물체의 형상, 두 손과 물체 간 접촉 정보 복원, 화면 재현 렌더링 품질 등에서 기존 기술보다 우수한 성능을 보인 것으로 나타났다.

백승렬 교수는 "이번 연구는 향후 VR, AR, 로봇 제어, 원격 수술 시뮬레이션 등 다양한 분야에서 실시간 상호작용 복원 기술로 활용될 것"이라고 말했다.

이런 연구 결과는 오는 11일부터 5일간 미국에서 열리는 컴퓨터 비전 분야 학회인 'CVPR 2025'에서 발표된다.

yongtae@yna.co.kr

Copyright ⓒ 연합뉴스 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.