[한국대학신문 윤채빈 기자] 국내 연구진이 민감한 개인정보를 외부 서버로 전송하지 않고도 고화질 이미지를 생성할 수 있는 초경량 인공지능(AI) 모델을 개발했다. 환자 MRI, CT 분석처럼 높은 수준의 보안이 요구되는 환경에서도 생성형 AI를 안전하게 활용할 수 있는 기술적 돌파구가 마련된 셈이다.

14일 울산과학기술원(UNIST)에 따르면, 유재준 인공지능대학원 교수 연구팀은 개인정보 침해 우려를 줄일 수 있는 새로운 연합학습 기반 AI 모델 ‘프리즘(PRISM, PRivacy-preserving Improved Stochastic Masking)’을 개발했다.

연합학습은 민감한 데이터를 서버에 직접 업로드하지 않고, 각자의 스마트폰이나 개인 장비에서 로컬 AI가 학습한 결과만을 서버에 전달해 하나의 글로벌 AI를 만드는 기술이다. 프리즘은 이 과정에서 로컬 AI와 글로벌 AI 사이를 매개하며, 학습 성과를 조율하는 ‘중재자’ 역할을 수행한다.

특히 프리즘은 기존 모델보다 통신 비용을 평균 38% 줄이고, 모델 크기도 48% 감소시킨 1비트 수준의 초경량 구조를 갖춰 스마트폰이나 태블릿 PC 같은 소형 기기의 CPU나 메모리에도 부담 없이 작동할 수 있다. 또한 로컬 AI마다 성능이나 데이터 품질의 차이가 큰 상황에서도, 어떤 정보를 더 신뢰하고 반영할지를 효과적으로 판단해 조율하기 때문에 최종 생성 결과물의 품질을 높이는 것이 특징이다.

예컨대, 셀카를 지브리풍 이미지로 바꾸는 AI를 사용할 경우 기존에는 사진을 서버에 업로드해야 해 개인정보 유출 우려가 있었다. 반면 프리즘을 이용하면 모든 처리가 스마트폰 내에서 이뤄져 사생활 침해 위험을 줄일 수 있으며, 처리 속도도 빨라진다.

연구팀은 기존의 대용량 파라미터 방식 대신, 중요 정보만 선별적으로 공유하는 ‘이진 마스크(Binary Mask)’ 방식을 도입해 통신 효율을 높였다. 또한 이미지 생성 품질을 정밀하게 평가하는 손실 함수(MMD, Maximum Mean Discrepancy)와 각 로컬 AI의 기여도를 다르게 반영하는 전략(MADA, Mask-Aware Dynamic Aggregation)을 적용해 데이터 편차와 학습 불안정성을 보완했다.

유 교수는 “이번 기술은 이미지뿐만 아니라, 텍스트 생성, 데이터 시뮬레이션, 자동 문서화 등 다양한 생성 AI 분야에 적용할 수 있다”며 “의료, 금융 등 민감 정보를 다루는 분야에서 효과적이고 안전한 솔루션이 될 것”이라고 말했다.

AI 기술을 둘러싼 사생활 침해 문제는 꾸준히 제기돼 왔다. AI 시스템이 대량의 데이터를 수집·저장하는 구조인 만큼, 민감한 정보가 유출될 가능성도 그만큼 높아지는 탓이다. 실제로 개인정보보호위원회가 2023년 12월 30일부터 2024년 1월 5일까지 ‘특정 AI 서비스 이용자 입력 데이터’를 분석한 결과, 전화번호 672건, 이메일주소 142건, 여권번호 34건, 주민등록번호 2건 등 총 850건의 민감 정보가 AI 시스템에 입력된 것으로 확인됐다.

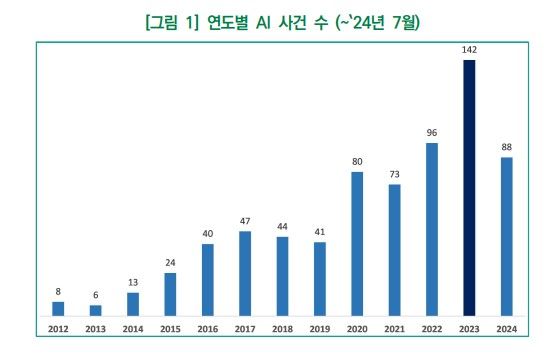

또한 소프트웨어정책연구소가 발표한 ‘책임 있는 AI를 위한 기업의 노력과 시사점’ 보고서에 따르면, 2023년 AI 관련 사고는 총 142건으로 전년(96건) 대비 48% 증가했다. 2024년 7월 기준 이미 88건이 발생한 상황으로, 같은 추세가 유지될 경우 2024년 연말에는 150건을 넘어설 것으로 전망했다. 이에 따라 유럽연합(EU), 미국 등 주요국은 정부 주도로 AI 안전 연구소를 설립하거나 민관 협력을 통한 위험 관리 체계 구축에 나서고 있다. 학계에서도 책임 있는 AI 및 안전한 AI 개발을 위한 기술적 연구가 활발히 진행 중이다.

AI 기술의 활용 가능성과 위험성이 동시에 확산되는 가운데, 이번 연구가 AI의 활용 가능성을 확장하면서도 개인정보 보호라는 윤리적 과제 해결에 실마리를 제공할 수 있을지 주목된다.

Copyright ⓒ 한국대학신문 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.