로봇이 새로운 환경에서 원활하게 작업하려면 처음 보는 물체도 빠르고 정확하게 인식하는 능력이 필수이다. 하지만 기존 AI 비전 기술은 사전에 학습한 데이터에 포함된 물체만 인식할 수 있어, 미학습 물체에 대한 인식률이 떨어지는 한계가 있었다.

국내 연구진이 이러한 문제를 해결할 혁신적인 인공지능(AI) 기술을 개발해 로봇 비전, 자율주행 등 다양한 분야에서의 활용이 기대되고 있다.

광주과학기술원(GIST, 총장 임기철)은 AI융합학과 이규빈 교수 연구팀이 오류 추정을 통해 미학습 물체의 인식 결과를 정제하는 AI 기술을 개발했다고 밝혔다. 이 기술은 실시간으로 오탐지된 물체를 삭제하거나 추가하는 기능을 갖추고 있어, 로봇의 시각 인지 능력을 한층 향상시킬 것으로 보인다.

현재 널리 사용되는 AI 비전 기술에는 몇 가지 한계가 있다. Mask R-CNN(2018) 모델은 사전에 학습된 물체만 인식할 수 있어 새로운 물체를 구별하는 능력이 부족하다. Segment Anything(2023) 모델은 사용자의 입력(클릭, 박스, 텍스트 등)을 기반으로 임의의 물체를 탐지할 수 있지만, 사람의 도움이 없을 경우 복잡한 환경에서는 정확도가 떨어지는 문제가 있다.

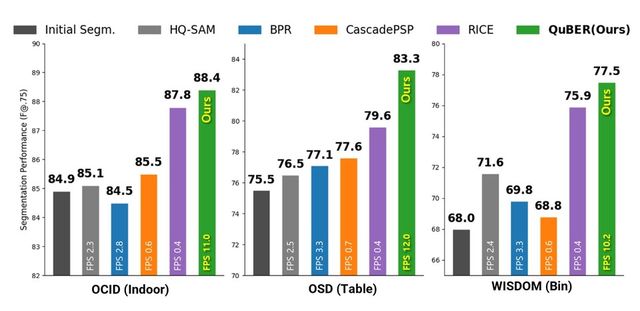

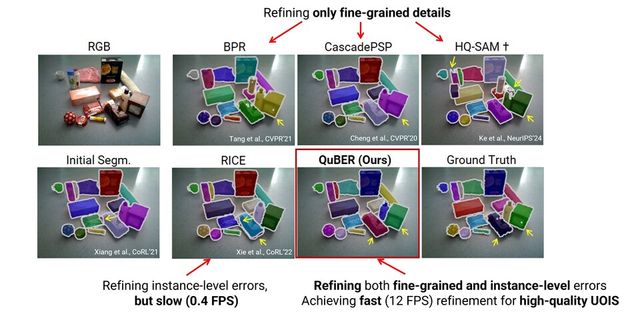

이를 해결하기 위해 이미지와 초기 예측 데이터를 기반으로 오류를 정정하는 기술이 개발돼 왔다. 하지만 기존 기술은 세부적인 부분만 수정하거나, 잘못된 인식을 정정할 수 있어도 작동 속도가 느리다는 단점이 있었다. 연구팀은 이러한 문제를 해결하기 위해 빠르고 정확한 오류 정정 기술을 적용한 ‘QuBER’ 모델을 개발했다.

QuBER 모델은 RGB-D(Red‧Green‧Blue-Depth, 컬러+깊이) 이미지와 초기 예측 데이터를 활용해 ‘4자 경계 오류(Quadruple Boundary Error)’를 분석함으로써 물체 인식의 정확도를 높이는 것이 특징이다. 이 기술을 통해 처음 보는 미학습 물체도 실시간으로 빠르고 정확하게 인식할 수 있다.

이처럼 4자 경계 오류(Quadruple Boundary Error)는 AI 비전 기술의 정확도를 높이는 데 핵심적인 기법으로 주목받고 있다.

이 기술은 AI의 초기 예측값과 실제 데이터(Ground Truth) 간의 차이를 ▴True Positive 경계(올바르게 검출된 경계) ▴False Negative 경계(검출해야 했지만 놓친 경계) ▴False Positive 경계(잘못 검출한 경계) 그리고 ▴True Negative 경계(검출하지 않아야 할 부분을 정확히 비검출한 경계) 등 네 가지 경계 기준으로 분석해 물체 인식의 오류를 효율적으로 정정한다.

연구팀이 개발한 QuBER 모델은 가려진 물체가 많아 인식이 어려운 상황에서도 빠르고 정확한 분할 능력을 보이며 세계 최고 수준의 정확도를 기록했다. ▴실내 환경(OCID)에서 88.4%의 인식률 ▴테이블 위 물체들(OSD)에서 83.3%의 정확도 ▴상자 안의 복잡한 물체들(WISDOM)에서 77.5%의 정확도를 보였다.

이규빈 교수는 “이번 연구를 통해 로봇이 처음 보는 물체도 정확하고 효율적으로 인식할 수 있다는 가능성을 확인했다”며, “이 기술이 다양한 로봇 작업에 적용돼 새로운 환경에서도 안정적으로 동작하는 로봇 개발에 큰 역할을 할 것”이라고 기대감을 나타냈다.

GIST AI 융합학과 이규빈 교수가 지도하고 백승혁 박사가 박사과정 재학 중 수행한 이번 연구는 산업통상자원부와 과학기술정보통신부의 지원을 받았으며, 로봇 분야 세계 최고 권위의 학회인 IEEE 국제 로봇 자동화 학술대회(ICRA, International Conference on Robotics and Automation)에서 2025년 5월 발표될 예정이다.

Copyright ⓒ AI포스트 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.