최태원 SK그룹 회장이 4일 서울 코엑스에서 열린 ‘SK 인공지능(AI) 서밋 2024’에 참석해 이렇게 말하며 주도권을 잡은 AI 반도체에 자신감을 드러냈다. AI 생태계 중에서도 엔비디아가 중심에 있는 만큼 SK하이닉스는 큰 영향력을 미치고 있다. 이날 행사에선 젠슨 황 엔비디아 최고경영자(CEO)와 웨이저자 TSMC CEO가 영상으로 깜짝 등장하며 SK하이닉스와 견고한 삼각 동맹을 증명했다.

|

◇ “HBM4 6개월 당긴다”…삼각동맹 견조

최 회장은 이날 ‘협력으로 만들어가는 AI 생태계’를 주제로 기조연설을 진행했다. 평소와 달리 파란 체크 남방을 입고 검정 뿔테안경을 쓴 채 편안한 차림으로 무대에 섰다. SK AI 서밋은 SK그룹 차원에서 매년 개최하는 행사로 올해는 대규모 글로벌 행사로 확대해 열렸다.

최 회장은 이날 황 CEO와 일화를 공개하며 6세대 HBM4 공급을 6개월 앞당기기 위해 준비 중이라고 밝혔다. 최 회장은 “엔비디아와 HBM4 공급 계획 약속이 끝나 있었는데 황 CEO가 일정을 6개월 당겨달라고 요청했다”며 “곽노정 SK하이닉스 사장을 쳐다봤는데 ‘한 번 해보겠다’고 대답하더라”고 웃으며 말했다.

이어 그는 “황 CEO는 한국 사람 같다”며 “‘빨리빨리’하며 속도를 중요시한다”고 덧붙였다. 현재 인텔 등 글로벌 기업들이 AI 가속기 개발을 시작했지만 엔비디아가 매년 새로운 버전의 칩을 내놓으며 격차가 더 벌어지는 상황이다. 최 회장은 “아직까진 엔비디아가 압도적이고 독보적”이라며 “엔비디아의 GPU가 나올 때마다 많은 HBM을 요구하고 있는데 개발을 적시에 맞추고 양산 수율을 맞추는 건 쉬운 일만은 아니다”고 설명했다.

|

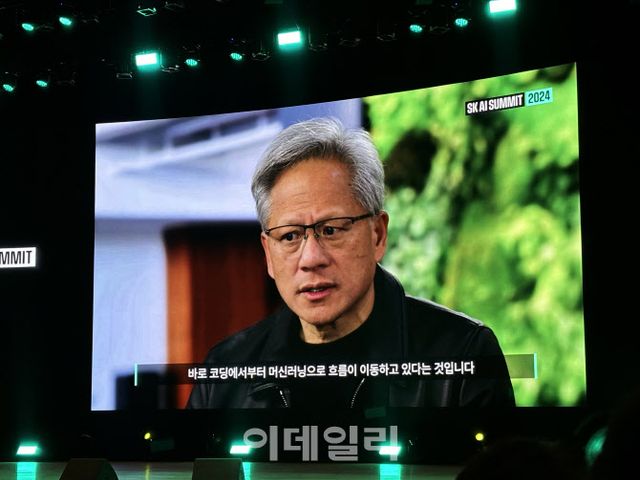

◇ 젠슨 황 “HBM으로 ‘무어의 법칙’ 넘어”

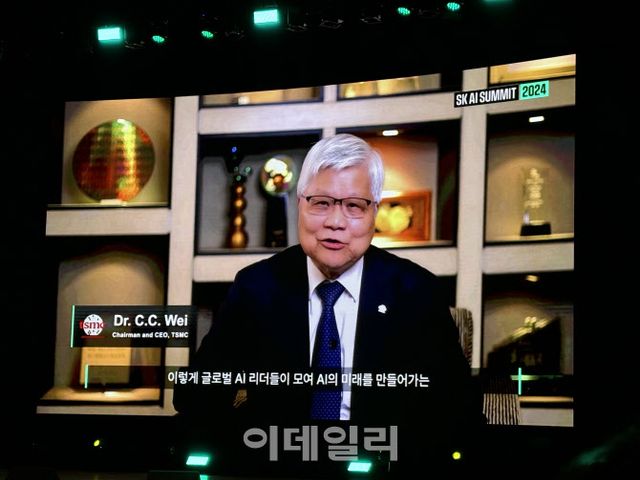

이날 SK하이닉스와 공고한 협력을 증명하듯 황 CEO와 웨이저자 TSMC CEO가 영상을 통해 행사에 깜짝 등장하기도 했다. 황 CEO는 “SK하이닉스와 엔비디아가 함께한 HBM 메모리 덕분에 ‘무어의 법칙’을 뛰어넘는 진보를 지속할 수 있었다”며 “우리가 설계하는 아키텍처와 잘 맞물려 돌아가게 해주고, 우리는 많은 측면에서 공동 설계를 진행하고 있다”고 강조했다.

웨이 CEO 또한 “SK하이닉스의 HBM이 오늘날의 데이터 집약적인 환경에서 AI 가속화의 중추 역할을 수행하고 있다”며 “바로 이런 파트너십 정신이 저를 가장 설레게 한다”고 말했다. 이어 웨이 CEO는 “생태계 전반에 걸친 더 긴밀하고 깊은 협력만이 새로운 가능성을 열어낼 수 있을 것”이라고 했다. SK하이닉스는 TSMC의 공정을 활용해 HBM을 생산하고 이를 엔비디아에 공급하는 삼각동맹을 이루고 있다.

모리스 창 TSMC 창업자는 과거 최 회장이 SK하이닉스를 인수하기로 했을 당시 “동업자가 된 걸 환영한다”고 반긴 것으로 전해졌다. 최 회장은 “(창 창업자가) 앞으로 우리가 파트너로 잘될 수 있다고 생각한다며 계속해서 저한테 관심과 의지를 표명을 해줬다”며 “지금도 TSMC와 어느 정도의 관계를 끈끈하게 잘 맺고 있는 것 같다”고 설명했다.

|

◇ “AI 발전에 ‘협력’ 중요…에너지 난제 풀어야”

최 회장은 AI 발전을 위한 ‘협력’을 강조하면서도 앞으로 직면할 난제를 언급하며 함께 풀어나가야 한다고 강조했다. 생성형 AI 수준으로 LLM 하나를 만들려면 대규모언어모델(LLM)당 10기가와트가 있어야 하는데 설령 AI 데이터센터를 짓는다고 해도 전력망 공급이 문제로 떠오른다.

최 회장은 대규모 전력량을 마련하면서도 에너지 독립성도 확보해야 하기 때문에 동시에 저전력 반도체, 액침냉각, 유리기판 등 다양한 솔루션이 중요해진다고 언급했다. 최 회장은 “대용량의 전력이 있다고 해도 현재 전력망, 송전망은 이 정도의 전기를 소화하지 못한다”며 “망을 개선하는데 비용이 더 들기 때문에 에너지 양도 중요하지만 독립적인 형태의 전기를 끌어오는 것도 필요하다”고 말했다.

그는 그러면서 “양과 송전의 방법, 탄소를 줄이는 방법을 모두 해결해야 데이터센터 문제를 해결한 것”이라며 “SK가 칩부터 에너지, 데이터센터 구축 운영, 서비스 개발, 유스케이스(적용 사례)까지 커버하는 회사다. 전 세계에선 흔치 않은 기업”이라고 덧붙였다.

Copyright ⓒ 이데일리 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.