카카오는 AI(인공지능) 서비스 운영 과정의 리스크를 관리하는 프로세스를 정의한 '카카오 ASI'를 구축했다고 23일 밝혔다.

카카오 ASI는 AI 기술 개발 및 운영 과정에서 위험 발생을 최소화하고, 안전하고 윤리적인 AI 시스템을 만들기 위한 종합 지침이다.

기술의 설계부터 개발, 테스트, 배포, 모니터링 및 업데이트 등 AI 시스템의 전 생애 주기에서 발생할 수 있는 리스크에 선제적인 대응이 가능한 것이 특징이다.

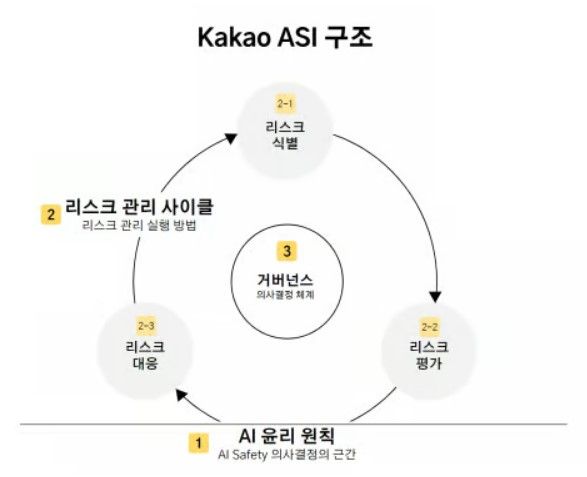

카카오 ASI는 카카오 AI 윤리 원칙, 리스크 관리 사이클, AI 리스크 거버넌스라는 3가지 핵심 요소로 구성됐다.

카카오 AI 윤리 원칙은 지난해 3월 발표한 '카카오 그룹의 책임 있는 AI를 위한 가이드라인'을 기반으로 한다. 사회 윤리, 포용성, 투명성, 프라이버시, 이용자 보호 등 원칙을 포함한다. 개발자와 사용자를 대상으로 윤리적인 가이드라인을 제공한다.

리스크 관리 사이클은 리스크를 체계적으로 다루기 위한 접근법이다. 식별과 평가, 대응의 순환 단계로 짜였다. AI 기술의 비윤리, 불완전 등을 최소화하고, 안전성과 신뢰성을 확보하는 역할을 한다.

AI 리스크 거버넌스는 AI 시스템의 개발, 배포, 사용 등을 관리·감독하는 의사 결정 체계를 의미한다. 조직 내 정책, 절차, 책임 구조 및 외부 규제와의 조화를 포함하며, 거버넌스 체계 안에서 관련 리스크들을 다각도로 검토한다.

김경훈 카카오 AI 세이프티 리더는 "AI 시스템 이용에 따른 리스크의 발생 주체를 AI와 인간으로 구분하고, 발생 주체별 리스크의 특성을 반영해 평가 및 대응 방안을 마련했다는 점이 타사의 AI 리스크 관리 프레임워크와 차별화되는 점"이라고 말했다.

Copyright ⓒ 일간스포츠 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.