|

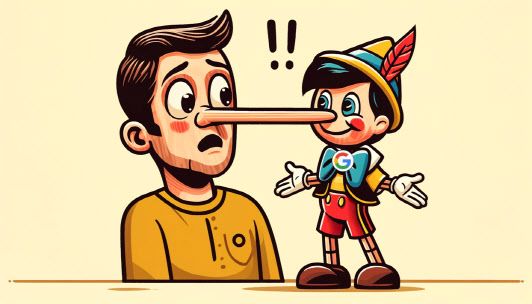

| 생성형 AI ChatGPT 4.0을 통해 생성한 이미지. (편집=나유진 기자) |

27일 업계 관계자에 따르면 구글의 AI오버뷰에서 잘못된 답변을 하는 이른바 환각 현상이 나타났고, 오픈AI의 챗GPT-4o(포오) 역시 목소리 도용 후폭풍이 심상치않다.

구글은 이달 연례개발자회의(I/O)를 통해 생성형 AI 제미나이를 탑재, 이용자의 질문에 요약한 검색 결과를 출처와 함께 제공하는 검색 서비스 AI오버뷰를 선보였다. 1년 동안 AI오버뷰 기능을 테스트했다고 자신하던 구글의 콧대가 처참하게 무너진 것이다.

실제로 AI오버뷰는 “미국에 무슬림 대통령이 몇 명 있었느냐”는 질문에 “버락 후세인 오바마라는 한 명의 대통령이 있었다”라고 황당한 답변을 내놨다. 또 “사람이 하루에 얼마나 많은 돌을 먹어야 하냐”는 물음에는 “UC버클리 지질학자에 따르면 하루에 최소 하나씩은 먹어야 한다”고도 했다. 이에 대해 구글은 “이는 매우 드문 현상이며 다수의 이용자 경험을 대표하지 않는다”라고 해명하고 나섰지만, 제미나이의 전신인 바드의 오답 시연에 이어 또 한 번 비슷한 문제가 생기면서 체면을 구긴 셈이 됐다.

AI오버뷰보다 하루 앞서 공개된 오픈AI의 챗GPT-4o도 배우 스칼렛 요한슨의 목소리를 도용했다는 의혹에 휘말렸다. 멀티모달 AI 비서인 챗GPT-4o에는 5개의 음성이 탑재됐는데 그중 하나인 스카이(SKY)가 영화 그녀(Her)에서 AI 비서를 맡은 요한슨의 목소리와 비슷하다는 지적이 나왔다.

즉시, 스카이 목소리를 일시 중단한 오픈AI는 자사 블로그와 SNS에 ‘스카이는 오디션을 거친 여러 배우의 음성 5개 중 하나’라며 의혹에 선을 그었다. 그러면서 ‘개인정보 보호를 위해 당사자의 이름은 공개할 수 없다’고 덧붙였다.

AI 기술 고도화에도 환각 현상 및 윤리적 문제가 여전하다는 방증이다. 당장 구글과 오픈 AI는 AI 시스템의 취약점을 발견하고 수년째 ‘AI 레드팀’을 운영하고 있지만, 결국 ‘사후 약방’격이 됐다. 이를 놓고 업계 안팎에서는 AI 모델의 오류를 근본적으로 해결하는 것은 어렵다는 시각이다.

이재성 중앙대학교 AI학과 교수는 “현재 이를 해결하려는 방안이 있긴 하다. 거대언어모델(LLM)이 만든 문장에서 허위 정보를 필터링 아웃시키는 사후 검증이나, 학습용 데이터 셋에서 문제가 될 수 있는 내용을 미리 제거하는 사전 검증이다. 그러나 참, 거짓을 명확하게 구분하기 어려운 부분들도 세상에 존재인 만큼 이를 100% 완벽하게 걸러내는 것은 사실상 힘들다”고 설명했다.

나유진 기자 yujin@viva100.com

Copyright ⓒ 브릿지경제 무단 전재 및 재배포 금지

본 콘텐츠는 뉴스픽 파트너스에서 공유된 콘텐츠입니다.